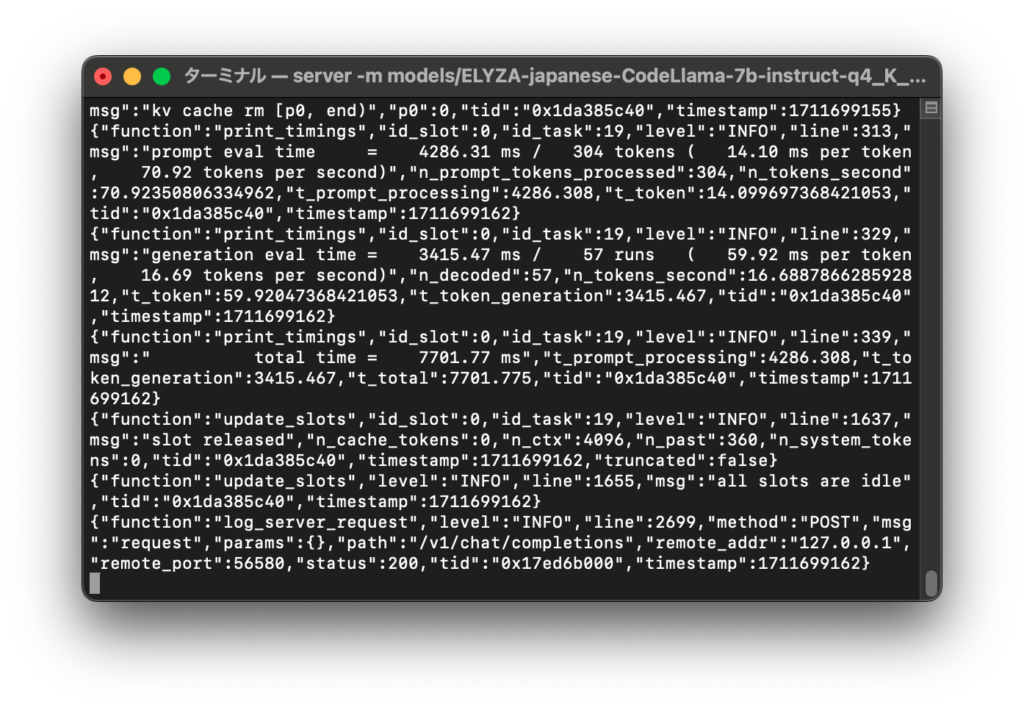

[Mac M2 Pro 12CPU, Sonoma 14.3.1, clang++ 15.0.0]

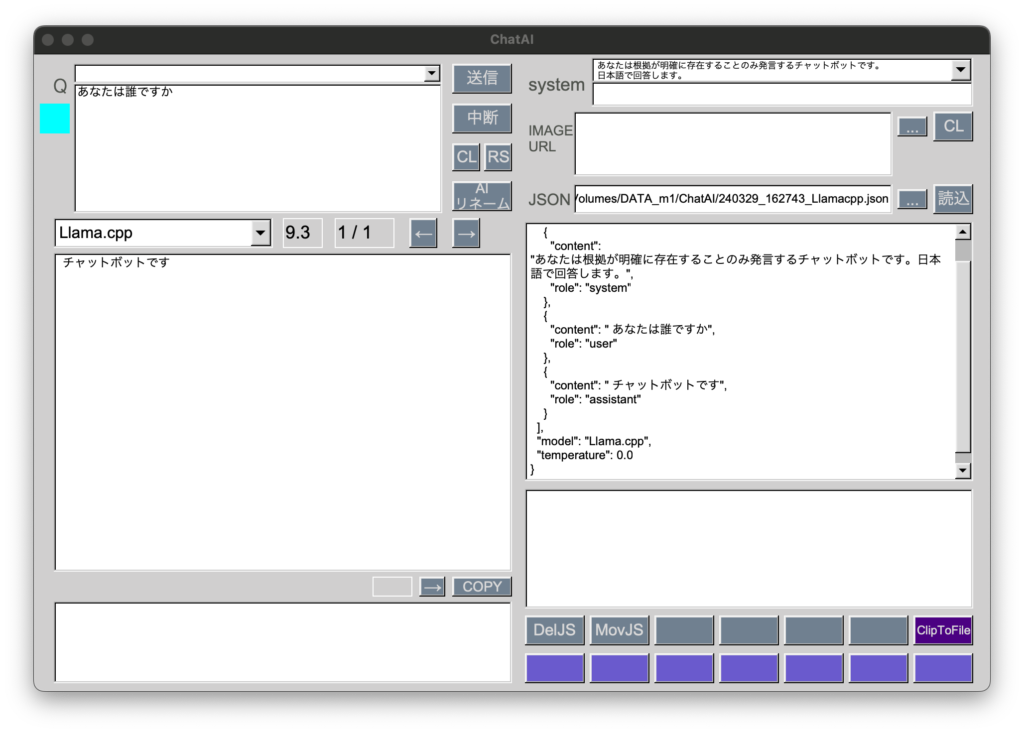

llama.cppでOpenAI互換APIサーバを立ち上げ、ChatGPTのようにチャットできるようにしました。

モデルは ELYZA-japanese-CodeLlama-7b-instruct-q4_K_M.gguf です。

cd /Volumes/DATA_m1/AI/llama.cpp && ./server -m models/ELYZA-japanese-CodeLlama-7b-instruct-q4_K_M.gguf -ngl 1 -c 4096サーバのURLは以下のようになります。

url : http://localhost:8080/v1/chat/completions