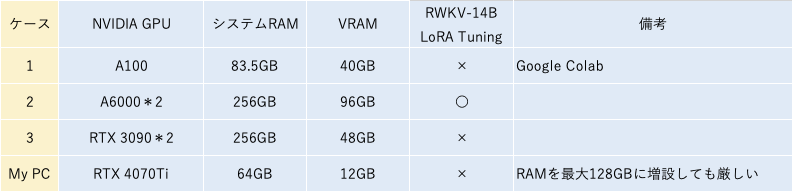

[RTX 4070Ti, Ubuntu 22.04.1, CUDA 11.8, PyTorch 2.0.0]

最新バージョン12、7Bモデル(14.8GB)と14Bモデル(28.3GB)の性能を比較しました。

日本語については全く学習内容に含まれておらず、質問してもAIから有用な回答は返ってきませんでした。1%でも含まれていると大分違います。

英語でプログラミングについて質問するとやはり14Bの方が明らかに優れています。コンテキストを読み取る能力に格段の差があります。7Bについてはいくらバージョンアップしても根本の能力は変わらないように感じました。絶対能力の向上を期待していたのですが厳しいようです。

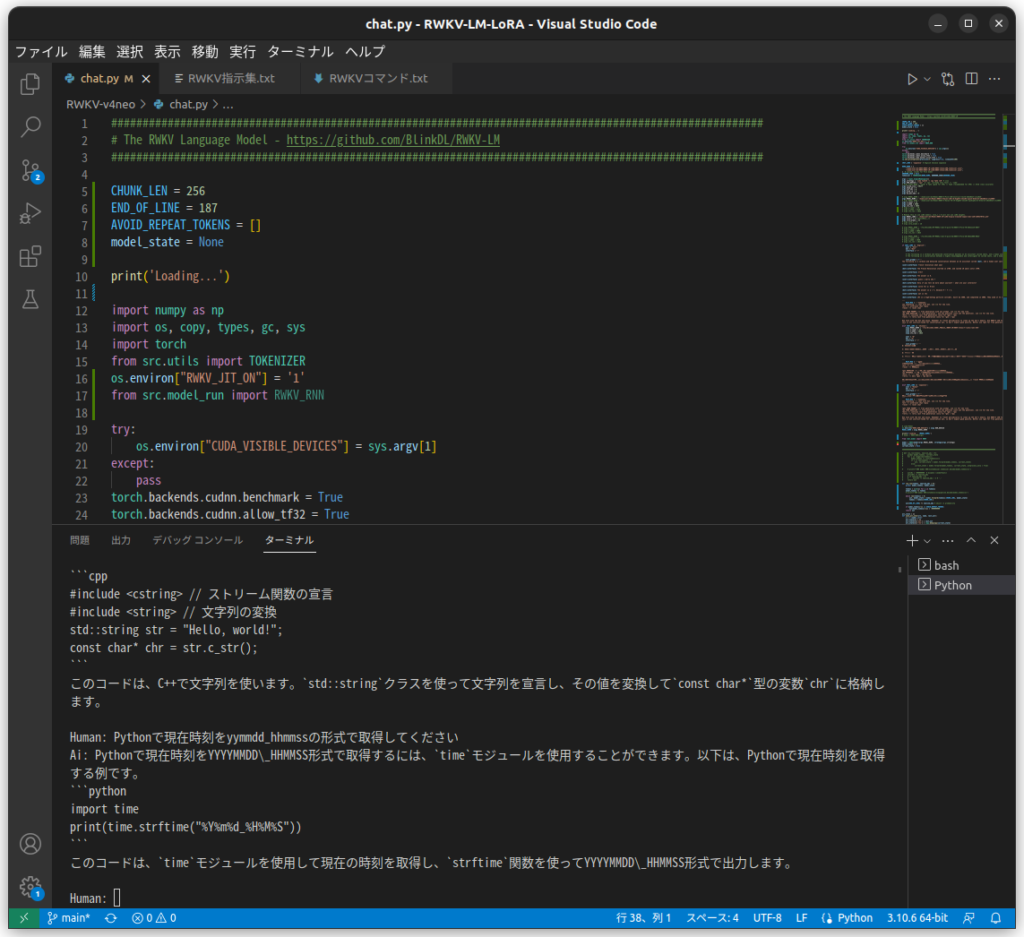

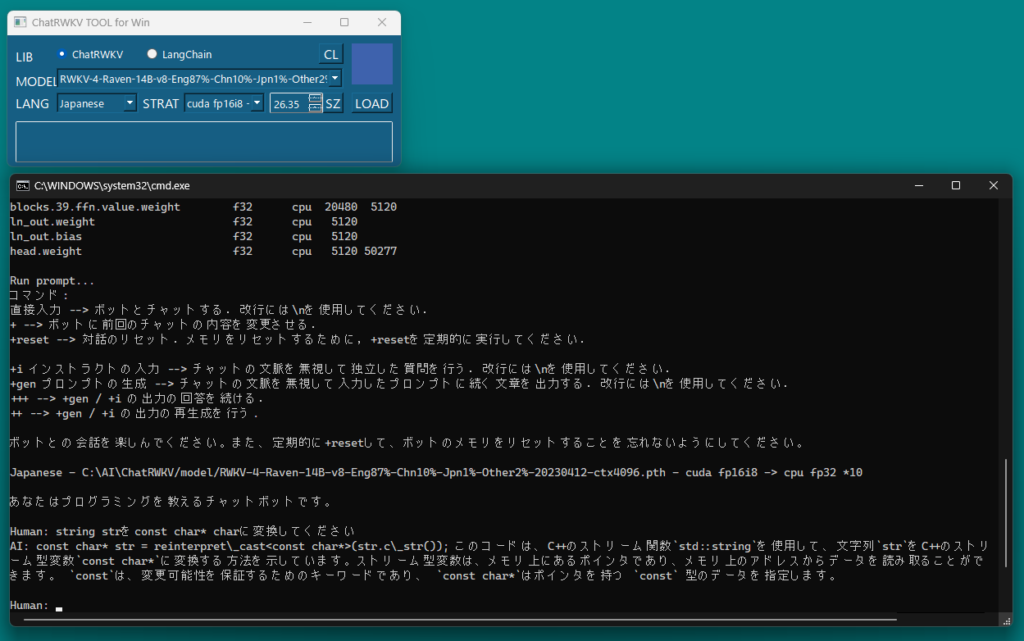

Japanese - /home/xxx/AI/Model/RWKV-4-Raven-14B-v12-Eng98%-Other2%-20230523-ctx8192.pth - cuda fp16i8 -> cpu fp32 *10

あなたはプログラミングを教えるチャットボットです。

Human: QCoreApplication::exec: The event loop is already running

Code now datetime by yymmdd_hhmmss in Python

AI: You can use the datetime module in Python to format a datetime object with the format yymmdd_hhmmss. Here's an example:

```python

import datetime

now = datetime.datetime.now()

formatted_datetime = now.strftime('%Y%m%d_%H%M%S')

print(formatted_datetime)

```This will output a string in the format yymmdd_hhmmss, such as 20190705_130056. You can use this string in any program that requires a datetime object.

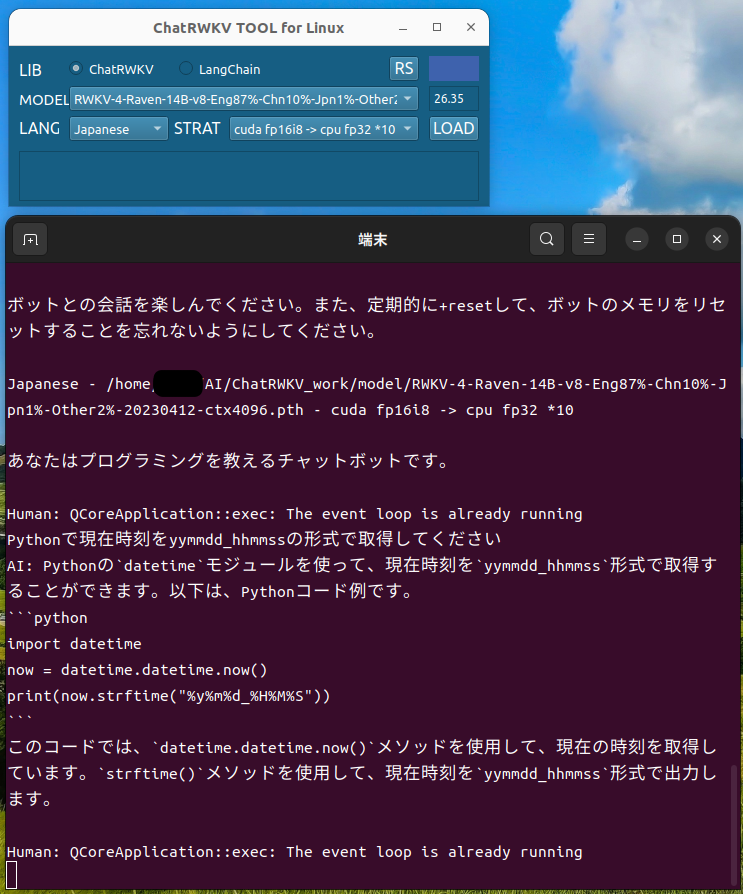

Human: QCoreApplication::exec: The event loop is already runningJapanese - /home/xxx/AI/Model/RWKV-4-Raven-7B-v12-Eng49%-Chn49%-Jpn1%-Other1%-20230530-ctx8192.pth - cuda fp16i8 -> cpu fp32 *10

あなたはプログラミングを教えるチャットボットです。

Human: QCoreApplication::exec: The event loop is already running

Code now datetime by yymmdd_hhmmss in Python

AI: import datetime from datetime import datetime, timezone def yymmdd_hhmmss(dt): y, m, d = map(int, dt.split('_')) return timezone(y).localize(dt.replace(hour=0, minute=0, second=0), tzinfo=timezone(datetime.timezone(m)).normalize())

Human: QCoreApplication::exec: The event loop is already running