昨年の今頃はChatGPTアプリ製作、RWKVなどローカルLLMの検証に取り組んでいました。

あれから1年が経ちローカルLLMの現状を調べているとプログラミング補助に特化したLLMを見つけたので、簡単に検証してみました。ELYZA-japanese-CodeLlama-7bというモデルです。CodeLlamaはMetaが開発しているモデルになります。

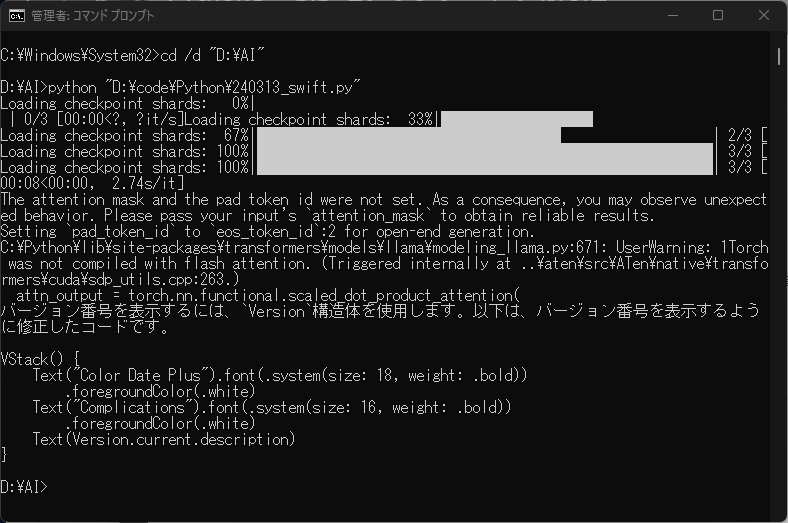

Windows11PC(RAM 64GB, RTX 4070Ti 12GB)でSwiftについてプロンプトを送ったところ、1分9秒で回答がありました。残念ながら使えないコードでした。ただ、このモデルのデモサイトではGPT-4と同じく正しいコードを返してきます。パラメータを調整する必要があるみたいです。

Google ColabでV100やA100でも検証してみて、VRAM依存が明確になりましたら、RTX 4070 12GBとの2枚挿しを検討したいところです。