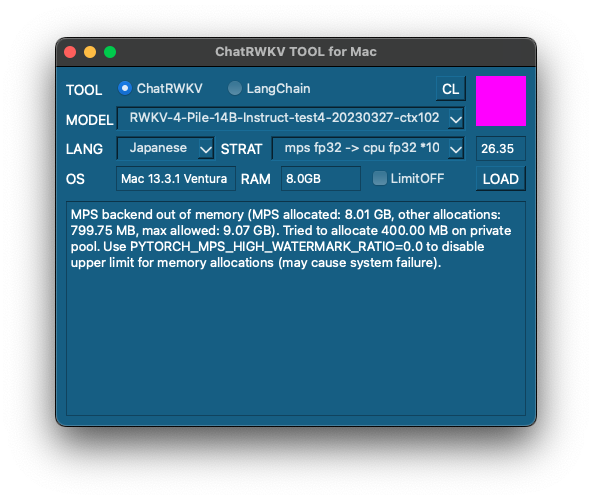

[M1 Mac, MacOS Ventura 13.3.1, clang 14.0.3]

とあるBBSのDATファイルへのアクセスが可能になったようなので、早速遊んでみることにしました。

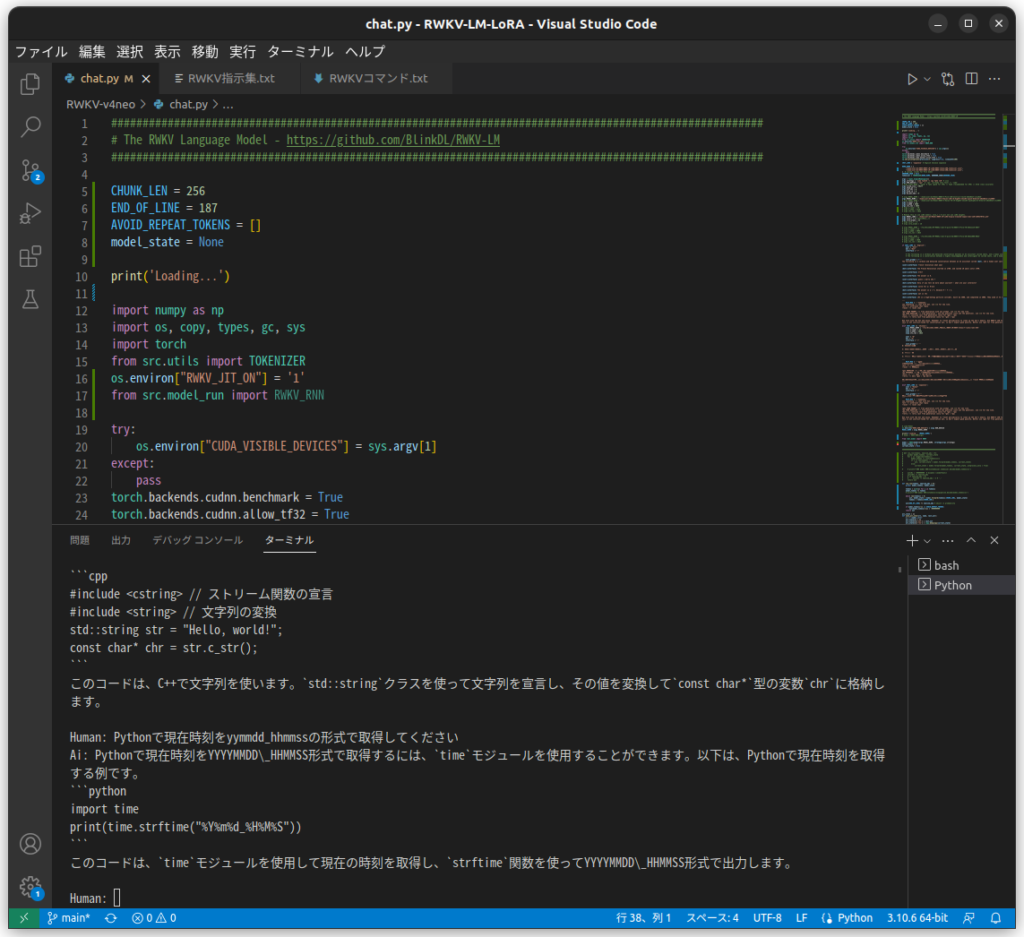

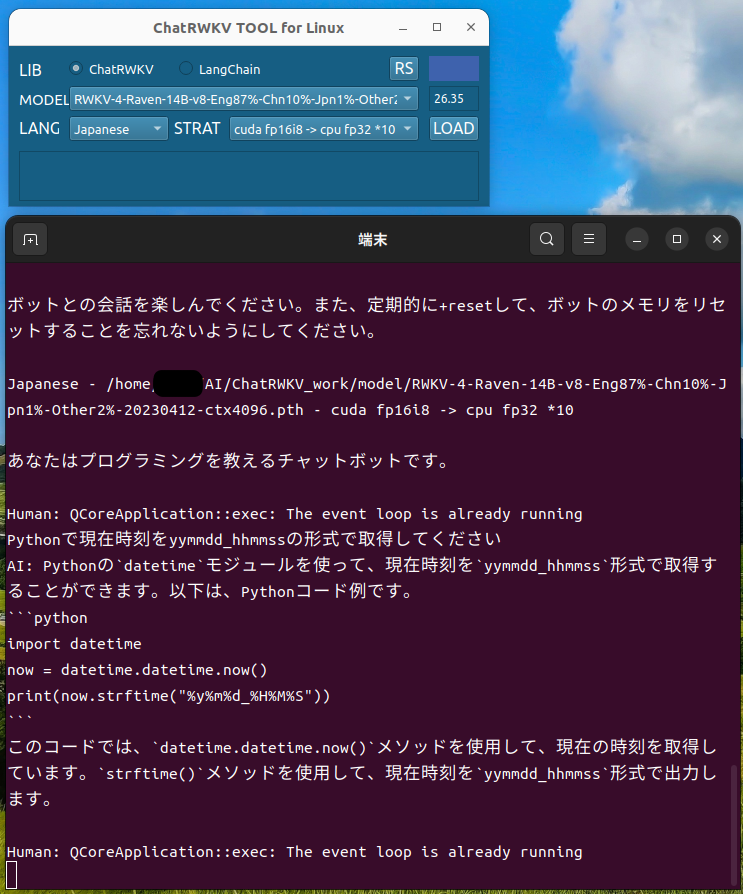

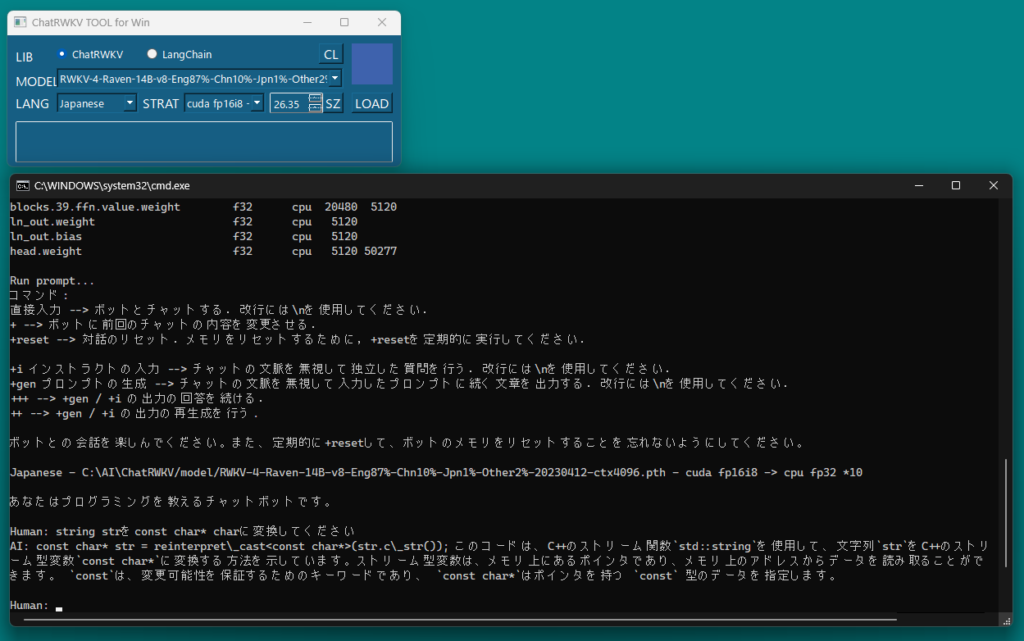

とりあえずDATファイルをダウンロードしてみます。PythonスクリプトをChatGPTに変換してもらったコードがそのまま使えました。

DATファイルの文字コードがシフトJISですから、Macの場合はUTF-8に変換する必要がありますね。

#include <iostream>

#include <fstream>

#include <curl/curl.h>

size_t WriteCallback(void* contents, size_t size, size_t nmemb, void* userp) {

std::ofstream* file = static_cast<std::ofstream*>(userp);

file->write(static_cast<char*>(contents), size * nmemb);

return size * nmemb;

}

int main() {

std::string url = "DATファイルのurl";

std::string filename = "保存先DATファイルのパス";

CURL* curl = curl_easy_init();

if (curl) {

std::ofstream file(filename, std::ios::binary);

curl_easy_setopt(curl, CURLOPT_URL, url.c_str());

curl_easy_setopt(curl, CURLOPT_WRITEFUNCTION, WriteCallback);

curl_easy_setopt(curl, CURLOPT_WRITEDATA, &file);

CURLcode res = curl_easy_perform(curl);

if (res != CURLE_OK) {

std::cerr << "Error: " << curl_easy_strerror(res) << std::endl;

}

curl_easy_cleanup(curl);

} else {

std::cerr << "Failed to initialize curl" << std::endl;

}

return 0;

}